개요

- handpose, face, pose - detection의 model type은 모두 CNN

- = 즉 모델의 전반적인 구조, 학습하여 결과를 도출하는 방식이 모두 CNN을 근본으로 하고, 모델 아키텍처도 advanced CNN 의 양상을 띄고 있음

- 따라서 이번 글에서는 CNN이 포함된 큰 카테고리인 DNN을 설명하기 위해 NN (Neural Network)을 먼저 설명하고, 다음 글에서 DNN에 대해 설명할 것임

- 구체적인 CNN에 대해서는 face-detection 시리즈에서 설명할 예정임.

1. 의미

- 인공 신경망 모형 (Artificial Neural Network): 일반적으로 artificial은 떼고 말함

- 뇌 구조 (신경망)을 모방하여 만든 수학적 모형

= 즉 인간의 뇌가 문제를 해결하는 방식과 유사하게 구현 - 머신러닝의 한 분야

2. 함수 구조

수식

그림

용어 설명

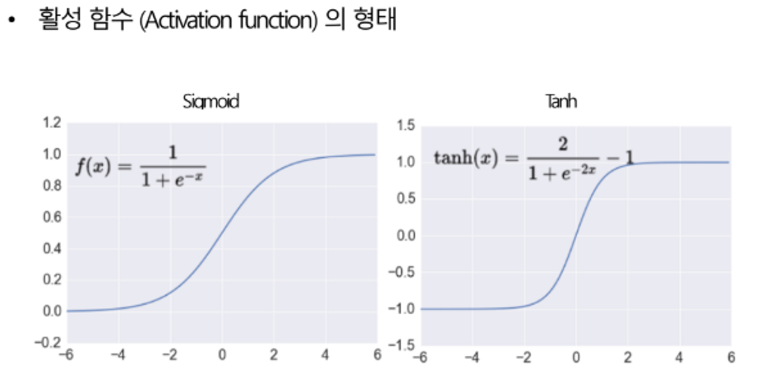

- 활성 함수 (activation function)

- 인공 신경망에서 입력 신호의 가중치 합을 출력 신호로 변환하는 함수

- 특징: 비선형성 (non-linearity) -> 입력에 대한 비선형 변환을 통해 신경망이 다양한 종류의 복잡한 함수를 학습

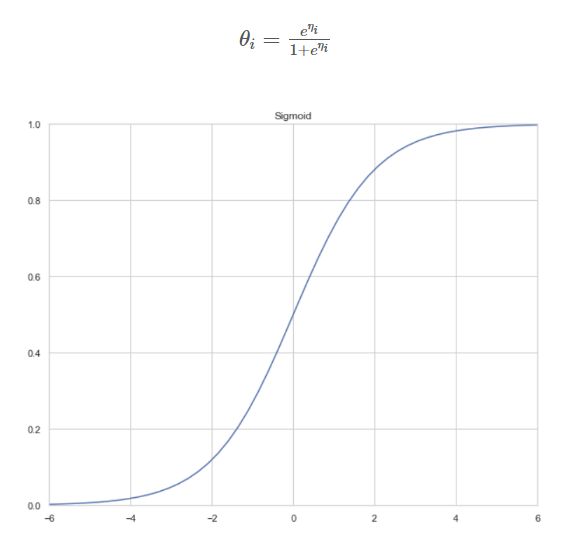

- 활성 함수의 형태

- 은닉층 (hidden layer)

: 입력층 (input layer)과 출력층 (output layer) 사이에 위치하는 모든 층 - 완전 연결 계층 (fully connected layer)

: 한 층(layer)의 모든 뉴런이 그 다음 층(layer)의 모든 뉴런과 연결된 상태

3. 이론적 성질

논문 원문

- Universal approximator (Cybenko, 1989 and Homik et al, 1989)

- Theorem 2 of Cybenko (1989)

해석

N을 충분히 키울 수 있으면 (여기서는 무한대로 표현됨), 모든 계층의 모든 x에 대하여 f(x)는 실제 함수의 합인 G(x)와 정밀도 ϵ (0보다 큰 아주 작은 값)만큼 가깝게 표현 가능

<-> N을 충분히 키울 수 있으면, Neural network를 표현한 f(x)는 다양한 함수 형태로 표현될 수 있음

<-> t가 +-무한대로 가면, 활성함수 (여기서는 sigmoid)가 +-1로 감

'AI > Image' 카테고리의 다른 글

| [Tensorflow-models] hand-pose-detection - 3. Deep Neural Network (1) | 2023.12.27 |

|---|---|

| [Tensorflow-models] pose-detection - 1. Model card (1) | 2023.12.22 |

| [Tensorflow-models] face-landmarks-detection - 1. Model card (0) | 2023.12.22 |

| [Tensorflow-models] hand-pose-detection - 1. Model card (1) | 2023.12.20 |

| [Tensorflow-models] 머신러닝과 딥러닝의 개념 (1) | 2023.12.19 |